随着人工智能技术的快速发展,越来越多的企业和开发者开始涉足AI项目的开发与部署。一个合适的服务器配置对于AI项目的成功至关重要。本文将详细介绍人工智能开发与部署所需的服务器配置,以及相关的网络技术开发要点。

一、硬件配置要求

- 中央处理器(CPU)

- 多核心高性能CPU:AI训练和推理任务通常需要大量的并行计算,建议选择至少16核心以上的CPU,如Intel Xeon或AMD EPYC系列。

- 高主频:高主频的CPU能够提升单线程任务的执行效率,对于某些AI模型的推理阶段尤为重要。

- 图形处理器(GPU)

- 高性能GPU:深度学习模型的训练对GPU性能要求极高。NVIDIA的Tesla、A100或RTX系列是常见选择,显存建议至少16GB,对于大规模模型可能需要32GB或更高。

- 多GPU配置:对于复杂的AI任务,多GPU并行计算可以显著提升效率。服务器应支持多GPU插槽和高速互联技术(如NVLink)。

- 内存(RAM)

- 大容量内存:AI模型训练和数据处理需要大量内存,建议配置至少64GB,对于大规模项目可能需要128GB或更高。

- 高带宽内存:选择DDR4或DDR5内存,以确保数据读写速度能够满足AI计算的需求。

- 存储系统

- 高速固态硬盘(SSD):AI项目涉及大量的数据读写,建议使用NVMe SSD作为主存储,以提升数据加载速度。

- 大容量硬盘:对于数据存储和备份,可以搭配大容量的HDD或SATA SSD。

- RAID配置:通过RAID技术提升数据冗余和读写性能。

- 网络接口

- 高速网卡:建议配置10GbE或更高速率的网卡,以确保数据传输效率,特别是在分布式训练场景下。

- 低延迟网络:对于实时AI应用,低延迟网络至关重要。

二、软件环境配置

- 操作系统

- Linux系统:大多数AI开发环境基于Linux,如Ubuntu或CentOS,因其稳定性和对高性能计算的良好支持。

- 开发框架与工具

- 深度学习框架:如TensorFlow、PyTorch等,需根据项目需求安装相应版本。

- 编程语言:Python是AI开发的主流语言,需安装相关库(如NumPy、Pandas)。

- 容器技术:使用Docker或Kubernetes可以简化环境部署和管理。

- 驱动与库

- GPU驱动:安装最新版本的NVIDIA驱动和CUDA工具包,以充分发挥GPU性能。

- 加速库:如cuDNN、NCCL等,用于优化深度学习计算。

三、网络技术开发要点

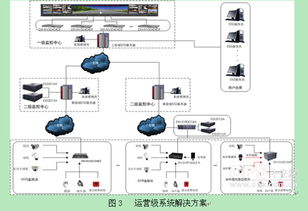

- 分布式训练

- 多节点协作:通过高速网络连接多台服务器,实现模型的分布式训练,提升训练效率。

- 通信优化:使用MPI或NCCL等通信库,减少节点间的数据传输延迟。

- 云原生与微服务

- 容器化部署:利用Docker和Kubernetes实现AI应用的快速部署和扩展。

- API开发:为AI模型提供RESTful或gRPC接口,便于与其他系统集成。

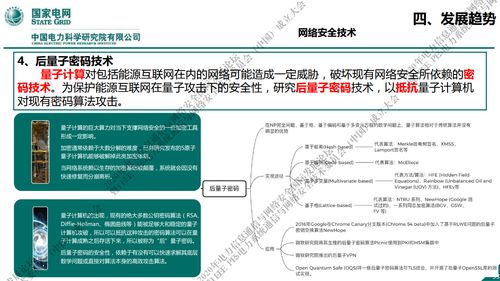

- 网络安全与数据隐私

- 加密通信:使用TLS/SSL协议保护数据传输安全。

- 访问控制:通过防火墙和身份验证机制,限制未授权访问。

四、实际部署建议

- 根据项目规模选择配置:小规模项目可选择单台高性能服务器,大规模项目需考虑集群部署。

- 弹性扩展:利用云计算平台(如AWS、Azure)的弹性资源,根据需要动态调整服务器配置。

- 监控与优化:使用监控工具(如Prometheus、Grafana)实时跟踪服务器性能,及时优化资源配置。

人工智能开发与部署的服务器配置需要综合考虑硬件性能、软件环境和网络技术。只有合理配置,才能确保AI项目的高效运行和成功落地。